Внимательно изучив последние тренды, связанные с Tron, Solana, ETH2, можно увидеть, что большинство прогнозов уже реализованы на практике. Но есть ряд моментов, которые заметны только в числовом выражении.

Для наглядности было бы неплохо представить ряд тестов и тестовых обстоятельств, которые необходимо учитывать. Но сначала попробуем обсудить некоторые важные, общие моменты, от которых зависит прогноз на 2023-2025 и даже 2030 годы.

*Крайне важно знать, что данный материал написан не как теоретический опус, а как часть цикла статей 2019-2022 годов на Bits.media, который завершился первой и второй частями о семействе PoS.

Содержание

Эффект Даннинга Крюгера и PoS

После того, как основная часть статьи была уже написана, один из чатов Bits.media напомнил мне об этом эффекте. Определение эффекта следующее:

«Метакогнитивное искажение у низкоквалифицированных людей: они делают ошибочные выводы и принимают неверные решения, но не осознают этих ошибок из-за неполных знаний, навыков и умений, приходят к ложному определению пределов компетентности и переоценке своих способностей – к неизвестным областям знаний и новым действиям и вовлечены в них».

О чем здесь речь?

В семействе PoS это происходит постоянно с 2013 года. Пожалуй, самый яркий пример — Solana, которая, несмотря на огромные венчурные инвестиции и фан-маркетинг, до сих пор работает, как метко выразилось криптосообщество, «в обеденный перерыв». ” Недавний пример.

Дело в том, что мало внимания уделяется «солнечному блокчейну» и другим подобным архитектурным проблемам. Тому есть несколько причин:

-

Во-первых, при привлечении инвестиций проекты фокусируются на положительных, а не на отрицательных сторонах, и в итоге это превращается в публичную дорожную карту, которую проект хочет выполнить «во что бы то ни стало», и таким образом у проекта есть время на доработку основ не оставайся. Контрпример — Эфириум и переход на Эфириум 2.0: последовательное осознание недостатков семейства PoS позволило с самого начала решить ряд проблем. Да, уже более шести лет, но сразу в тестовой и производственной сети: не все, но многие из заявленных.

- Во-вторых, вокруг определенных групп программистов скапливается компетенция: это легко увидеть в сравнении солидных кодеров с RUST/Go, который только начал свой путь. Что это значит? А это значит, что оценить потенциально сложные моменты зачастую просто некому — это как впервые побывать на Красной планете: вряд ли Мэтт Дэймон справился с представленным набором трудностей так же лихо, как его герой из «Марсианина.

Если вы считаете, что этот вопрос чисто теоретический, то рекомендую интервью с Александром Скидановым, где он честно и открыто, исходя из понимания рынка, рассказывает об изменении стратегии и парадигмы Ближнего. На самом деле, если мы на минуту отойдем от семейства PoS, проблема будет унаследована блокчейнами всех уровней и моделей: BCH/BSV — живые примеры.

Зная это, мы идем дальше.

Сбои vs финализация

Если вы помните основные принципы архитектуры семейства PoS, то обнаружите, что обычно обсуждаются три параметра, хотя они и не связаны друг с другом (чаще всего):

TPS как некий условный эталон оперативной работы блокчейна.

Завершение как второй корректирующий параметр.

Децентрализация: точнее уровень (чем выше, тем лучше).

Вот несколько примеров, чтобы было понятнее:

BSC (цепочка BNB: см ссылку для различий): Завершение за 33 секунды, но уровень децентрализации суперузлов страдает при любом подходе (см. Пример статистики). С одной стороны, такой подход позволяет быстро откатиться после взломов и других проблем, но с другой стороны, он мало чем отличается от классических финансов и, как следствие, не приносит пользы конечным участникам.

Полигон: если внимательно изучить все перипетии этой системы (надеюсь, что одна из будущих публикаций будет посвящена этой печальной цепочке – чуть ли не единственной из подсемейства Plasma), то станет ясно: в результате, 150+ подтверждений часто бывает недостаточно, и все это крайне сильно замедляет dApps и делает приложения нестабильными, что особенно заметно на примере межсетевых мостов.

Harmony: Если вам «посчастливилось» развернуть что-то в этой системе, особенно через грант, то вы, возможно, заметили, что в тестовой сети просто не так много устаревших приложений, и, следовательно, сквозных без корреляции к общественному согласию мало.

ChatGPT в помощь

Но это все общие аспекты. Попробуем аутентифицировать их через ChatGPT:

Время завершения: в блокчейнах с PoS, DPoS, LPoS и аналогичными алгоритмами консенсуса завершение может занять некоторое время. Что может привести к задержкам транзакций и ожиданию окончательного подтверждения. В некоторых случаях это неприемлемо для пользователей, ожидающих подтверждения.

Алгоритмы консенсуса могут быть более уязвимы к «атакам 51%»: например, в случае DPoS, когда небольшое количество участников имеет возможность контролировать большую часть блокчейна, это может привести к возможности атак 51%. В таких ситуациях завершение может быть нарушено, что приведет к угрозе безопасности сети. [Примечание Менаскопа: здесь, конечно, ИИ дал штрих, потому что обсуждение атак, указанных в первой и второй части исследования, было бы уместнее, но суть атаки он уловил через комбинацию сибилоподобных уязвимостей, так что оставим как есть].

Возможность отмены транзакций: В некоторых случаях, когда закрытие не является окончательным, транзакция может быть отменена. Это может произойти, если кто-то, участвующий в блокчейне, захочет изменить уже записанные данные. В некоторых случаях это может привести к финансовым потерям или другим проблемам. [Прим. Менаскоп: и здесь снова немного поправил, т.к в предыдущих частях обсуждалось именно это].

Недостаток децентрализации: в некоторых алгоритмах консенсуса, таких как PoS, LPoS и других, более крупные держатели криптовалют имеют большее влияние на решения, принимаемые в блокчейне. Это может привести к отсутствию децентрализации и возможному влиянию на процесс транзакции. Если несколько крупных владельцев договариваются между собой об отмене той или иной транзакции или блока, это может привести к сбою финализации и создать потенциальные проблемы в блокчейне. [Примечание Менаскопа: здесь ИИ снова перепутал главное, но я оставлю как есть, потому что для статьи важен вектор децентрализации].

Как видите, мне пришлось немного поправить тезисы ChatGPT, но в целом они верны. Попробуем теперь посмотреть на ситуацию со стороны практики и эмпиризма.

Примеры и истории

Начать, конечно же, стоит с EOS, проекта, на который многие возлагали такие же надежды: в 2018 году на EOS произошел сбой, который привел лишь к тому, что несколько валидаторов начали обрабатывать один и тот же блок. Что, в свою очередь, приводило к нарушению завершения транзакций. Отчет об этом можно найти в разных источниках, но я оставлю ссылку на этот твит, ибо найти его на сайте первых разработчиков не так-то просто. Сейчас.

Можно сослаться на то, что это было только при запуске, а можно вспомнить, что Qihoo360 за неделю до этого предупредил криптосообщество, что ошибок гораздо больше.

Именно по этой причине раз за разом делаются выводы о том, что EOS — это не блокчейн, а «распределенная однородная система управления базами данных, а рынок оперативной памяти — сервис облачных вычислений». С другой стороны, именно на этом примере мы видим, как первичная централизация (вторичная обсуждалась в первой части) в конечном итоге влияет на безопасность.

Фактически, тот факт, что социальный консенсус неоднократно становился более мощным инструментом, чем технический консенсус, привел к упадку DPoS-подсемейства Graphene (Bithsares/Steem/Golos/и т д.

Нет, причин много, но нас интересуют низкоуровневые паттерны: Tron vs Steem(it), EOS – пример выше, долгий разговор про Голос.ио – Голос.ид – все это как раз и есть противостояние фундаментальных технического и социального консенсуса, где преобладал последний. Всегда.

Поэтому суть повествования не в том, как интерпретировать ошибку и какие выводы из нее сделать, а в том, что эта проблема архитектурного уровня и будет развиваться в эпоху мультичейнов. Который? Давайте поговорим об этом ниже.

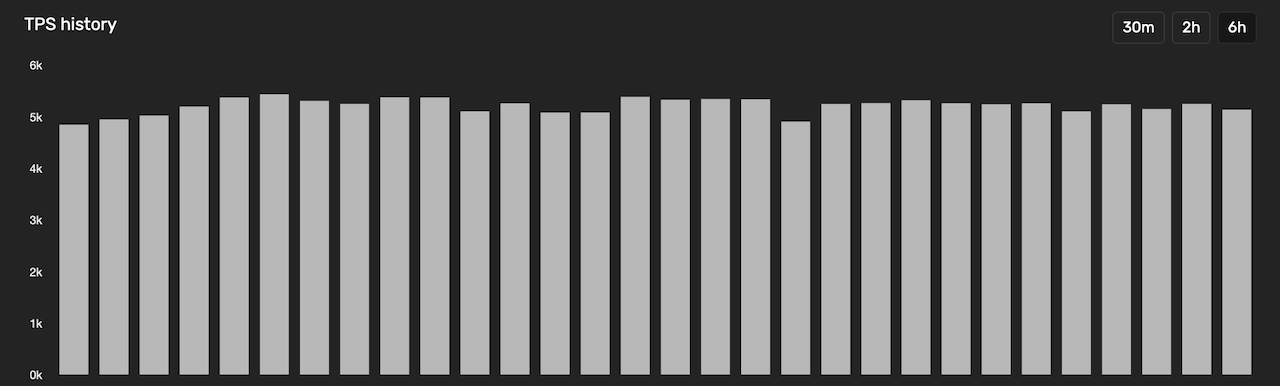

Тем временем первые цифры. Солана:

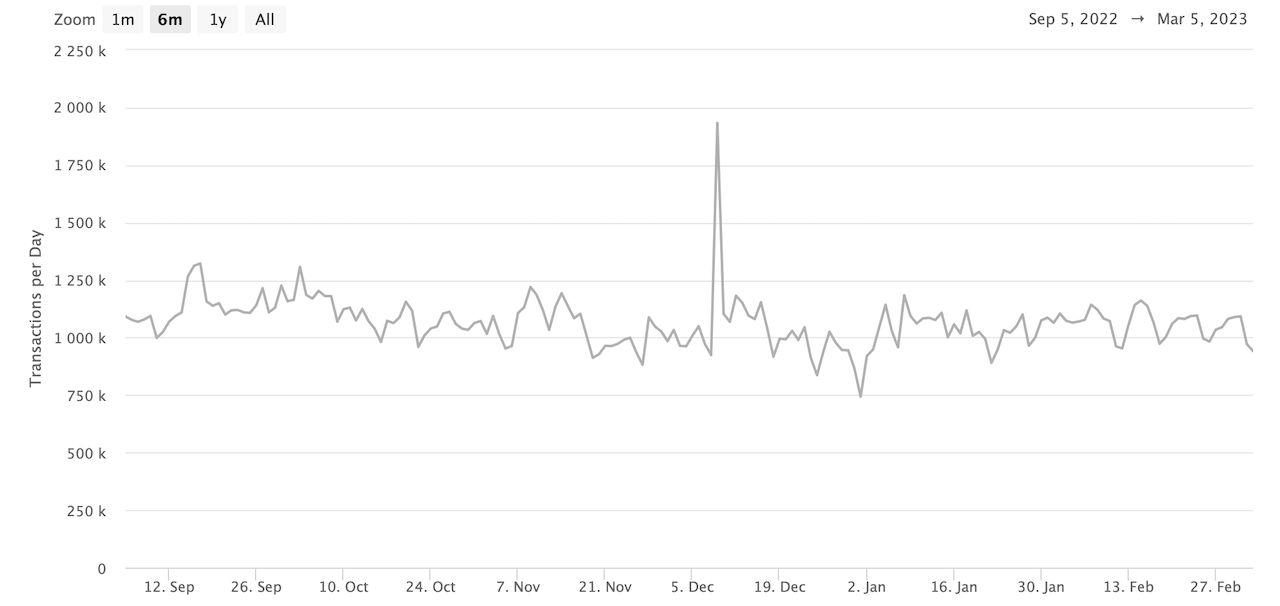

Эфириум

По сравнению с TPS Солана будет впереди с явным отрывом. Если провести более полную исследовательскую работу, как это делаем мы, то окажется, что гораздо важнее:

Не учитывайте (только) скорость транзакций и даже не скорость завершения, а сам механизм: если на этот процесс будет слишком большое влияние, блокчейн будет нестабильным.

Чрезвычайно важно учитывать передачу гипотетического TVL (общая заблокированная стоимость) за транзакцию: подробнее об этом см в следующем разделе.

Наконец, важно оценить уровень/степень децентрализации: начиная от супернод (валидаторов, делегатов и т д.) и заканчивая HODL — владельцами кошельков.

В отношении пункта 2 следующее означает:

Какова TVL для всего сегмента DeFi в конкретном блокчейне.

Каков процент длинных волн HODL, то есть тех, кто держит оригинальный токен (монету/монету) этого блокчейна три и более года.

Какова средняя прибыльность роботов MEV и других участников, которые от них зависят.

Какие еще финансовые параметры на момент сделки.

Опять же, все это может показаться излишним, но на практике это очень помогает.

Позвольте мне привести вам пример: если мы сравним количество реализованных смарт-контрактов BSC и Ethereum, Ethereum окажется в проигрыше. Визуально, статистически, что угодно. Но если к ним добавить экономические параметры, то получится прямо противоположное. И эта проблема известна давно: «дешевые, или почти бесплатные транзакции» в архитектуре на самом деле создают две уязвимости на уровне архитектуры:

Они демотивируют держателей суперузлов.

Они мотивируют создателей скам-токенов и подобных продуктов.

Вывод №01. От технологии к экономике

Получаем первый значимый вывод: эра технологического аспекта консенсуса не закончилась, но прошла первую зрелую стадию, тогда как эра экономического аспекта только началась.

Что это значит?

-

Во-первых, из-за растущей совместимости как на уровне L1, так и на уровне L2/L3 параметры стабильности будут иметь приоритет по сравнению с формальными показателями решений блокчейн/DAG.

-

Во-вторых, рано или поздно придется создавать рынок деривативов для технологического стека L1/L2, потому что иначе полноценно взаимодействовать с разными решениями невозможно.

-

В-третьих, суммирование первой и второй задач предполагает, что деятельность владельцев супернод должна иметь мульти- и кросс-чейн токенизацию, так как в противном случае невозможно оплатить положительные эффекты, необходимые для стабильной работы системы.

-

В-четвертых, получаем простую формулу: k = Стабильная_Работа/Безопасность, где Безопасность — безопасность L1/L2-систем, k — коэффициент прямой или обратной зависимости, а Стабильная_Работа — стабильность работы (нормальная работа систем).

Фактически, k определяет, как работает система. Покажи нам:

-

BSC (цепочка BNB) близка к формуле 3/1, то есть стабильность превышает безопасность;

-

Биткойн составляет около 1/1;

-

Солана – 1/3.

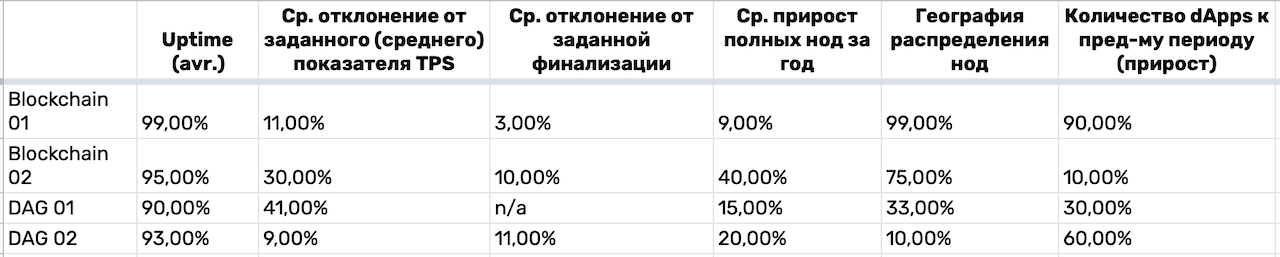

Для более точного расчета параметров каждый из них следует выразить как сумму других параметров в процентах. Такой:

1. Позвольте Среднему (Opetime) пройти градацию:

один. 100%-99% = 10%;

б) 98,9%-97% = 3%;

в) Менее 97% = 1%.

2. Далее — отклонение от среднего (вывод):

один. Менее 10% = 10%;

б) от 10% до 20% = 3%;

в) более 20% = 1%.

3. И так далее: это может быть 3, 5, 10 или 100 параметров — в зависимости от того, какой точности вы хотите добиться.

Вес параметра будет рассчитываться следующим образом: Parameter_Weight = 100%/Quantity(Parameters). В моем случае параметров 10, поэтому максимальный процент для каждого равен 10%.

Затем просто сложите: 10%+10%+…10% = 100% или меньше.

В таблице приведен пример расчета для тестовых и неполных параметров:

То же самое делаем с безопасностью. Сюда входят следующие показатели:

Количество суперузлов для обновления.

Количество краж в год.

Количество вилок в год.

Другие.

Тогда получим, например: 97/30 или 3,2(3). То есть параметр стабильности превалирует над безопасностью, то есть идеальным соотношением будет 1. Таким образом, можно одновременно рассматривать два архитектурно важных аспекта:

Абсолютный процент безопасности и стабильности.

Их отношения.

Можно усложнить формулу и добавить децентрализацию, но я рекомендую делать это после первоначального анализа стабильности и безопасности.

Зачем вообще это делать? Резонный вопрос. Постараюсь подробно ответить.

Вывод №02. PoS-семейство на развилке

Мы уже видели форки между сообществом (Hive vs Steem(it), ETH vs ETC, BCH vs BTC и т д.), мы уже видели технологические форки (в основном мягкие, но есть и жесткие, когда пахнет керосин, как с биткойном в 2010 году), но сейчас наступила эра финансово-экономических вилок, и они будут затрагивать слишком много сфер деятельности, чтобы упускать процесс из виду или не замечать его вообще.

Позволь мне объяснить.

Если покажется, что это теоретическое исследование, спешу возмутиться: нет, это уже практика. Приведу пример из доклада по экосистеме Cosmos: из-за того, что владельцы супернод перед запуском нового проекта оценивают финансовый аспект, фактически создается искусственная олигополия, где из-за отсутствия первичных (фундаментальных) и публичная токенизация работы консенсуса на уровне мультичейн/кроссчейн, это происходит искусственно. Проще говоря: кто первый – тому и тапки. Но при этом тапочки всегда идут производителю тапочек, хотя логично, что они должны достаться покупателям тапочек.

Я знаю как минимум два десятка команд, занимающихся валидацией и всем, что с ней связано. Обратная связь везде примерно одинакова: если ты не в топе, ты можешь пробиться либо (1) в трудные времена (как сейчас), либо (2) за счет чистой удачи, которая стремится к бесконечно малому значению из-за обязательность запусков: у проектов будут «проверенные деньги» и проверенные люди, у валидаторов — быстрая прибыль, как следствие — уровень децентрализации стремится к нулю, а с таким уровнем технологический консенсус сменяется социальным.

У этого есть и обратная сторона: посмотрите на полемику вокруг отмены ETH2 или отзыва валидаторов в Солане.

И там у нас узкое место – узкое место первичной дистрибуции: стек технологий не покрывает риск социального из-за изначальной централизации, а социальное не может решить технологическое из-за того, что команды решают проблемы по мере их возникновения, а не на уровне базовой архитектуры. (Кстати, переименование ETH2 — еще одно звено в этом процессе.)

Что же дальше?

Как когда-то PoW, а потом смешанный консенсус, а вслед за ними семейство PoS (которое можно считать семейством консенсуса только в широком смысле) сразу ударило в потолок (вертикальное масштабирование), в стены (горизонтальное масштабирование) и в пол (масштабирование с уровень базовых элементов в экономике-архитектуре).

Это очень легко проследить на примерах, которые берут «лучшее» из мира PoW и PoS: Decred, Dash и т д.

И это не значит, что произошло что-то непоправимое, но определенно указывает на то, что наступила эра новых систем. Отчасти описанные проблемы будут решены с помощью механики ЗКП, отчасти — за счет детализации элементов архитектур PoS, но все же часть останется за инновациями.

И здесь я попытаюсь поделиться рядом соображений.

Во-первых, все три части материалов PoS посвящены множеству вопросов, но большинство из них можно свести к одному: централизации ликвидности. Системы, способные решить эту проблему, на самом деле будут продвинутыми. Задача, в свою очередь, имеет три элементарных слоя:

Backend (это только уровень консенсуса и ниже).

Фронтенд (на примере Tornado Cash легко понять, что шаг в этом направлении сделан).

Взаимодействие с несколькими цепочками/соединениями в цепочках.

Здесь с прошлым разом явно никто не работает. Нет, это парачейны, субчейны, хабы, совместимость с EVM и так далее. Но как это решает проблемы совместимости на фундаментальном, архитектурном уровне? Никогда.

Вы можете снова взглянуть на пример мостов: да, поколение мостов, создающих обернутые активы, позади, и у нас есть возможность совершать транзакции в одно мгновение. Скажем, на allbridge использовать стандартные стейблкоины и/или другие монеты/токены, а не производные. Но как решить эту проблему? По сути, за счет полуавтоматического исполнения транзакций. Следующим шагом будет зачисление оригинальной монеты на кошелек получателя в нужной сети.

Что будет дальше?

Даже в этом чрезвычайно простом примере возникает следующее:

Есть транзакция в блокчейне #01 (скажем, Ethereum).

Есть транзакция в блокчейне #02 (скажем, Polygon).

Оба имеют суперузлы, от которых зависит передаваемое значение на каждом шаге.

Но конечная мотивация в этих двух транзакциях различна:

а) запускает клиент моста транзакции #01;

б) продолжается в цепочке №01, а затем №02 – сам мост;

в) а конечным получателем транзакции №02 может быть совершенно другое лицо и/или то же самое, что и отправитель.

Вам это ничего не напоминает?

Если мы заменим мост набором атомарных переключателей, а приемник/передатчик — суперузлами, то получим, что передача ценности по цепочкам мотивирует кого угодно, но не нижележащие L1-структуры, получающие от этого выгоду (на основе внутренней оценки) систем , т.е нативные монеты), а все остальные могут вообще не заработать.

Парадокс?

Я так думаю. Но пока что системы уже получают все больше инъекций от неофитов, а потому эта проблема либо вообще не рассматривается, либо рассматривается на уровне кастомных решений (опять же дальше всех они ушли в подсемействе EVM).

По сути, это решение тех проблем, которые обозначил Виталик Бутерин относительно перекрестной цепи как таковой.

Другое дело, что не все технологии еще достигли своего пика, чтобы повернуться к Джомалунгме, и поэтому нам, исследователям Web 3.0, киберсталкерам и IT-предпринимателям, пора закрыть эту черную дыру креативностью новых подходов.

На данный момент у меня есть все

Для!

PoS: проблемы и перспективы. Часть

PoS: проблемы и перспективы. Часть вторая: Атака